Le SEO est une topique en pleine effervescence en période post Covid en ce début 2022. D’une part la demande n’a jamais été aussi importante ce qui nécessite plus d’ingéniosité dans la conception de stratégies SEO et d’autre part les innovations des moteurs de recherche, Google et Bing notamment, sont de plus en plus perturbantes ce qui nécessite une compréhension à tous les niveaux : technique, sémantique et graphes en général qu’ils soient basés sur le social, les liens ou simplement le Knowledge.

Pour ceux qui me connaissent et qui ont déjà lu mes billets dans le passé, ils vont se rendre compte dans un shift d’approche de l’analyse : je passe des tactiques (Onpage et Off site) vers la stratégie globale. Dans ce billet vous trouverez ma lecture des tendances SEO pour 2022 bien plus au niveau technique que les nouveautés conceptuelles comme Google MUM, Discover ou IndexNow. En effet, pour ces dernières, vous pouvez suivre des gens plus compétents que moi, dans l’ordre : Jason Barnard, Glenn Gabe et Jean-Christophe Chouinard.

Cette année, je veux mettre l’emphase sur la nécessité de responsabiliser les TI à mettre leurs Babettes (comme on dit ici au Québec) et nous laisser effectuer notre travail dans les meilleures conditions. Voici les principales tendances SEO pour 2022 :

- L’aspect technique devient très important (crawl, indexabilité et accessibilité) et devrait être pris en charge par les équipes TI,

- Les marketeurs doivent penser en topiques et non en mots clés car les moteurs processent désormais le contenu sous forme de langage naturel (NLP),

- Les responsables PR doivent réajuster leurs stratégies pour améliorer le score E-A-T de leur business au niveau contenu et auteurs qui sont derrière.

Introduction et mise en contexte

Tout d’abord nous devons nous mettre d’accord sur la demande croissante en SEO. Joe HALL a fait un sondage auprès des professionnels du SEO qui a recueilli plus de 600 votes et le résultat est clair :

The pandemic has brought an increased demand in SEO.

— Joe Hall (@joehall) February 1, 2022

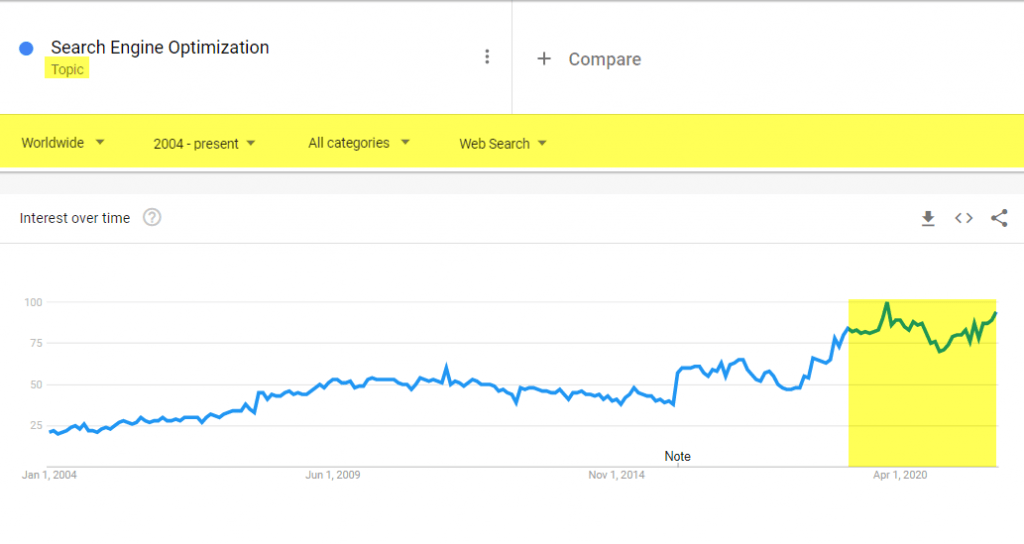

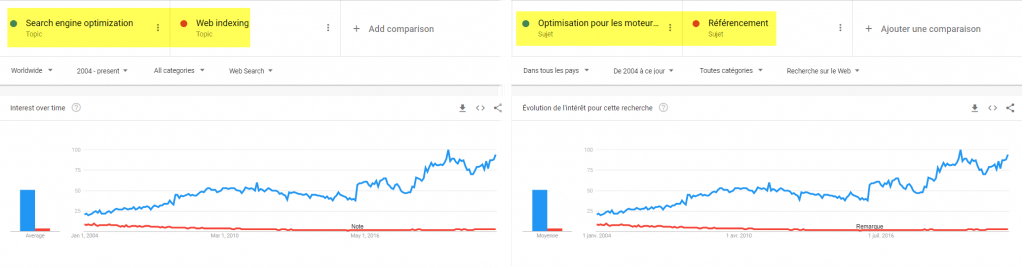

D’un autre côté Google trends, notre référence en matière de tendances et qui devrait être utilisé comme outil de décision (ou du moins d’arbitrage) par tout marketeur, montre la croissance :

Cette courbe montre l’intérêt pour la topique SEO en général mais nous pouvons vérifier via le trafic obtenu par la plus grosse agence de services SEO ainsi que la demande pour SEO Consultant :

Cette tendance ne va pas s’inverser car les prix du PPC ont juste atteint un niveau insoutenable pour les PME et les revenus de Google et Bing pour Q4 – 2021 le démontrent bien !

D’un autre côté, depuis que j’observe le développement technologique des moteurs que sont Google et Bing (le premier avec son Knowledge graph et le deuxième avec Wolfram dont j’ai parlé en 2012) sont entrain d’atteindre leurs niveaux de maturité bien qu’il reste encore beaucoup de chemin à faire pour atteindre l’excellence (recherche vocale, recherche prédictive et assistants personnalisés…). Mais nous sommes à un tournant où nous passons des mots clés vers les topiques (moving from strings to things).

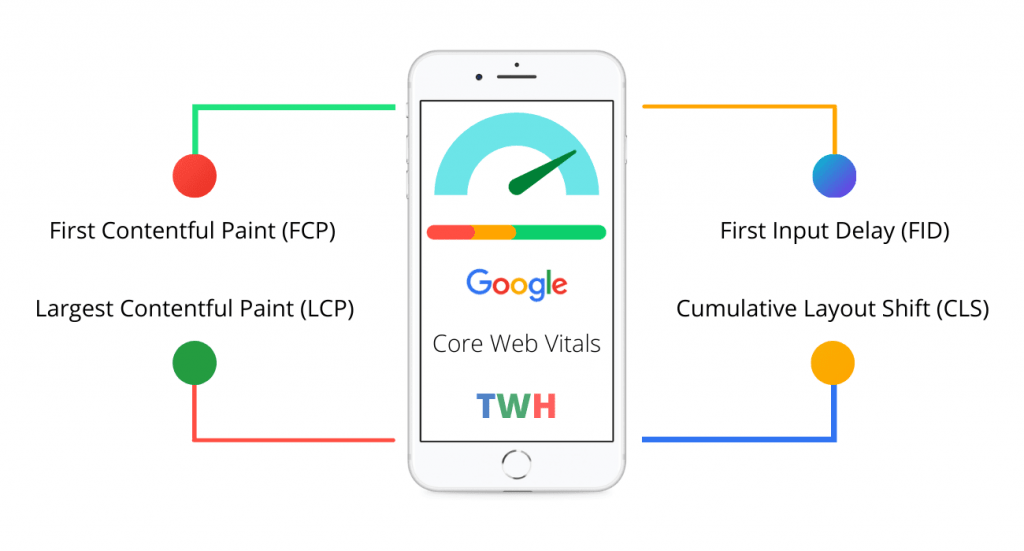

Comprendre le concept dessiné dans cette courte vidéo (est essentiel pour l’alignement entre les spécialistes du marketing et les devs, car nous entrons dans une nouvelle ère où les mots clés importent moins que le clustering, la modélisation des sujets et une bonne expérience (selon les derniers développements sur https://web.dev/).

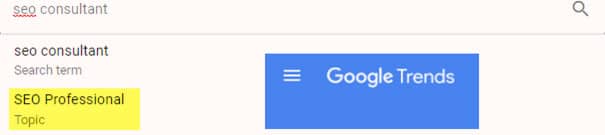

Ci-dessous en anglais, «SEO Consultant» est le mot-clé et «SEO Professional» est le sujet :

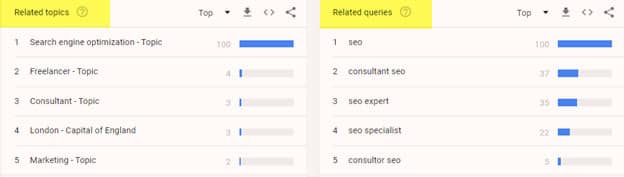

Lorsque vous choisissez le sujet, Google vous montrera les requêtes liées :

L’idée est qu’avant de cibler une requête, nous devrions, en tant que spécialistes du marketing, nous assurer que nous sommes pertinents (et idéalement les plus sûrs – pensez E-A-T) pour notre sujet principal. Dans les SERP de Google :

Ci-dessus, Google a construit les entités numériques sur la base de ce qui a été trouvé sur le Web (Schema et sources de confiance «Wikipédia, GBP, Social, News…»)

Bien qu’il n’y ait aucune garantie que vous serez classé pour les requêtes connexes, cela vous donne un avantage : Mozalami #3 sur «SEO Consultant Montreal» alors que je n’ai pas bloggué depuis 3 ans et aucun backlink entrant !

Maintenant il y a d’autres challenges à venir qui concernent plus l’infrastructure du web tel qu’on le connaît : le web3.0 (à ne pas confondre avec web 3.0 le web sémantique avec un espace).

Le Web 1.0 et Web 2.0 font référence à des époques de l’histoire du World Wide Web au fur et à mesure de son évolution à travers diverses technologies et formats. Le Web 1.0 fait référence à peu près à la période de 1991 à 2004, où la plupart des sites Web étaient des pages Web statiques, et la grande majorité des utilisateurs étaient des consommateurs, et non des producteurs, de contenu. Le Web 2.0 est basé sur l’idée de « le Web en tant que plate-forme » et se concentre sur le contenu créé par l’utilisateur partagé sur les médias sociaux et les services de réseautage, les blogs et les wikis, entre autres services. On considère généralement que le Web 2.0 a commencé vers 2004 et se poursuit encore aujourd’hui.

Web3 est distinct du concept de 1999 de Tim Berners-Lee pour un Web sémantique. En 2006, Tim Berners-Lee a décrit le Web sémantique comme un composant du Web 3.0.

Le terme «Web3» a été inventé par le fondateur de Polkadot et co-fondateur d’Ethereum Gavin Wood en 2014, faisant référence à un «écosystème en ligne décentralisé basé sur la blockchain». En 2021, l’idée de Web3 a gagné en popularité. En grande partie en raison de l’intérêt des passionnés de crypto-monnaie et des investissements de technologues et d’entreprises de haut niveau. Les dirigeants de la société de capital-risque Andreessen Horowitz se sont rendus à Washington, DC en octobre 2021 pour faire pression pour que l’idée soit une solution potentielle aux questions sur la réglementation du Web, auxquelles les décideurs politiques se sont attaqués. Certains auteurs se référant au concept décentralisé généralement connu sous le nom de «Web3» ont utilisé le terme «Web 3.0», conduisant à une certaine confusion entre les deux concepts.

Bien qu’il s’agisse d’un énorme changement dans les infrastructures et certainement dans les logiciels qui vont être utilisés sur ces plateformes, cela n’implique aucun changement en termes de comportement des utilisateurs. La recherche est le moyen naturel que les gens utilisent quotidiennement pour trouver des informations, des services, des produits, leur compte et bien d’autres choses…

Technique : crawlabilité, indexabilité et accessibilité

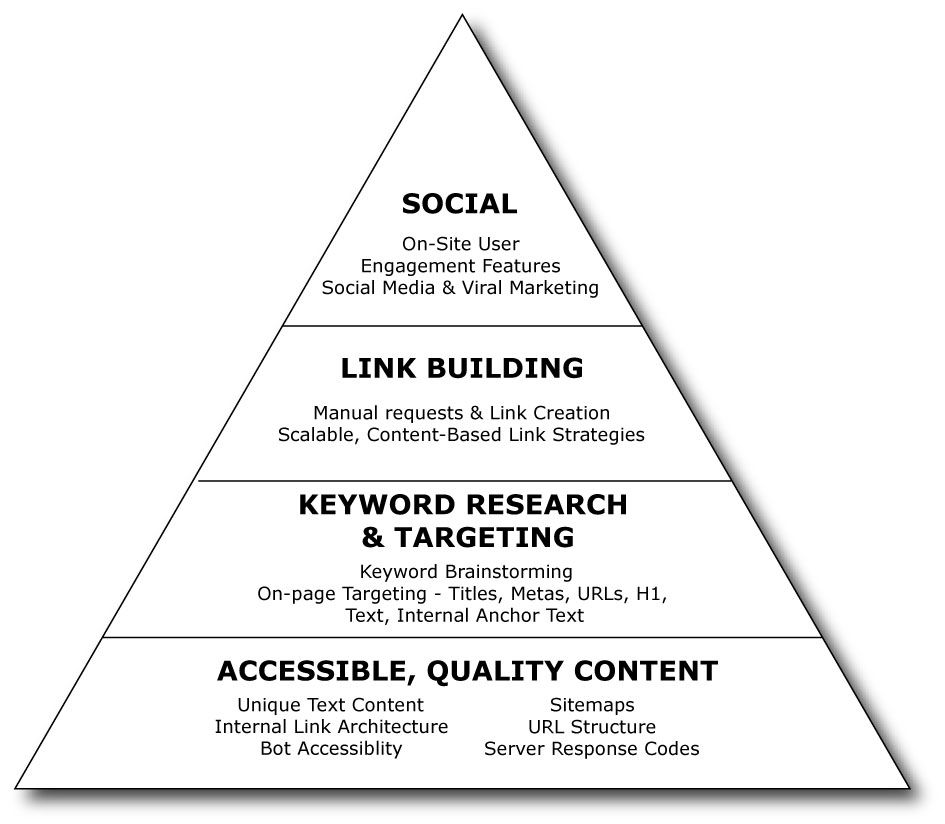

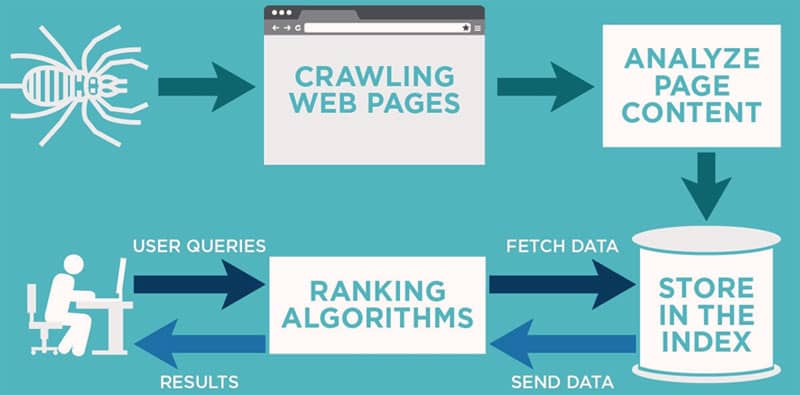

Il y a des choses qui sont immuables en SEO : si une page ou URL n’est pas indexée il n’y a rien à faire même si vous êtes le meilleur marketeur sur terre car il n’y a pas de produit à vendre. Pour cela, il peut y avoir plusieurs raisons : la page n’est pas crawlée et donc non découverte par les robots (cela arrive avec des boutons en JS car les moteurs ne cliquent pas) ou que la page existe sous d’autres versions qui sont considérées dupliquées (des paramètres de filtrage ou de tri ou tracking ou simplement mauvaise configuration au niveau programmation). Dans ce cas la page que vous voulez optimiser n’a pas été choisie comme canonical et tous vos efforts d’amélioration de contenu de profil de liens sont vains. Et puis il arrive que même si la page est accessible et indexée, son contenu n’est pas accessible (cela arrive par exemple avec les vidéos mal intégrées ou encore du texte invisible car il nécessite une action de l’internaute). Cette partie est cruciale car elle est à la base de la pyramide SEO que nous partageons depuis des années :

Pour être honnête je préfère celle-ci bien que très vieille et que nous partageons depuis 2010 grâce à notre ami Rand Fishkin car elle regroupe les fondamentaux : technique, contenu, backlinks et prominence (social, Google Business Profile, Wikipédia…). Il y a bien sûr des versions plus récentes comme celle partagé par @aleydasolis aujourd’hui même :

Cependant comme commenté dans ce post, je pense que nous pouvons en inventer autant qu’il y a des objectifs de business.

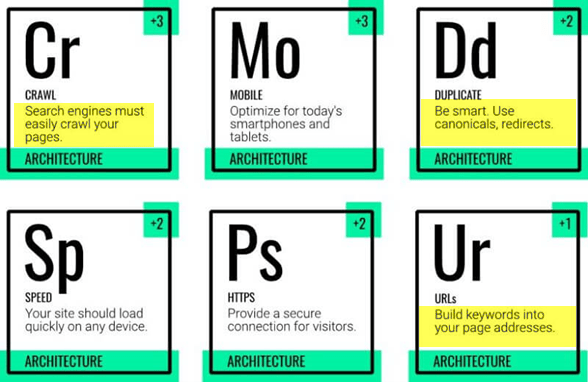

Retour à l’essentiel, dans cette pyramide à la base nous avons les performances techniques et celles-ci peuvent être décomposées à leur tour comme suit :

Si bien que nous pouvons zoomer un peu sur la pyramide dans la base et la structurer comme suit :

Ces trois parties doivent être prises en charge par les équipes en TI en 2022 pour diverses raisons :

- Ils sont les mieux outillés pour résoudre les problèmes

- Le budget de crawl nécessite l’analyse des logs auxquels ils sont les seuls à avoir accès

- Dans le web moderne, un utilisateur retrouve sa page via la recherche et non via les bookmarks naguère populaires. Donc l’argument des IT comme quoi ils conçoivent pour les utilisateurs pas les robots ne fait plus de sens.

Rajoutez à cela la tendance globale vers la durabilité (sustainability) mouvement éco, vert… Les moteurs sont pressés par la communauté mondiale afin de limiter les ressources consommées par l’armada de serveurs déployée dans le monde et qui a pour objectif de crawler, analyser et indexer les pages web.

Nous avons parlé du nouveau protocole IndexNow de Bing et Yandex, nous constatons aussi que Google veut diminuer son crawl par les voix de John Mueller, Martin Splitt, and Gary Illyes.

Non pas que nous autres experts SEO nous ne savons pas gérer cet aspect mais par mon expérience, cela coûte trop cher au client les allers-retours entre IT dev et SEO pour régler les problèmes ce qui résulte en une perte de temps et d’argent. Notre valeur ajoutée est de prioriser ce qu’il faut faire en SEO et non le faire !

Fait intéressant, une fois encore grâce à Google Trends, si on regarde la topique « référencement » en anglais cela donne : « WEB Indexing ». Tandis que SEO en français donne « Optimisation pour les Moteurs de Recherche ».

En toute franchise, nous n’avons plus besoin de vendre notre temps pour faire tout ce qu’on peut. Je prône la création d’une nouvelle discipline chez les spécialistes SEO en se concentrant sur le référencement des pages (je parle bien sûr de sites avec des milliers de pages voir des millions).

Malheureusement on voit que les premiers à avoir popularisé le terme SEO (en l’occurrence @dannysullivan qui a rejoint Google depuis avec Google public @searchliaison) ne sont pas des techniciens. Si bien que l’intérêt pour le référencement (indexation des pages web) qui représentait la moitié de la recherche du SEO est maintenant rendu à moins de 5% !

Il serait temps de renverser cette tendance et de demander aux développeurs de prendre en charge l’optimisation de l’index de Google en s’assurant d’une excellente qualité (pages crawlées en gérant le budget, pages indexées donc analysées et contenus accessibles). D’autant plus que Google vient de nous mettre à disposition une API pour inspecter les URLs avec un max de 2000 requêtes par jour mais que les IT peuvent utiliser pleinement en découpant le site en morceaux si trop gros :

Conclusion sur les nouvelles tendances en stratégie SEO pour 2022

Bien entendu il y a bien des évolutions qui ont lieu au niveau contenu avec Google qui établit de nouveaux standards au niveau qualité mais aussi au niveau interface (avis, coupons, jobs, vols, auto…). De même, il ne fait plus aucun doute que si tout le monde parlait de PageRank en 2010 et à juste titre, les liens étaient la principale source de confiance au début, maintenant nous devons nous préoccuper du score E-A-T qui lui n’a pas de barre verte dans le navigateur ou indicateur public de Google ou autre moteur de recherche. Mais si nous restons pris avec les problèmes de base (crawlabilité, indexabilité et accessibilité) nous n’avons aucune chance de relever les défis qui nous attendant dans cette décennie !

Tags: Stratégie, SEO, tendances seo